22 Fév 2021

22 Fév 2021Mythe #4 : Plus de données = plus d’insights

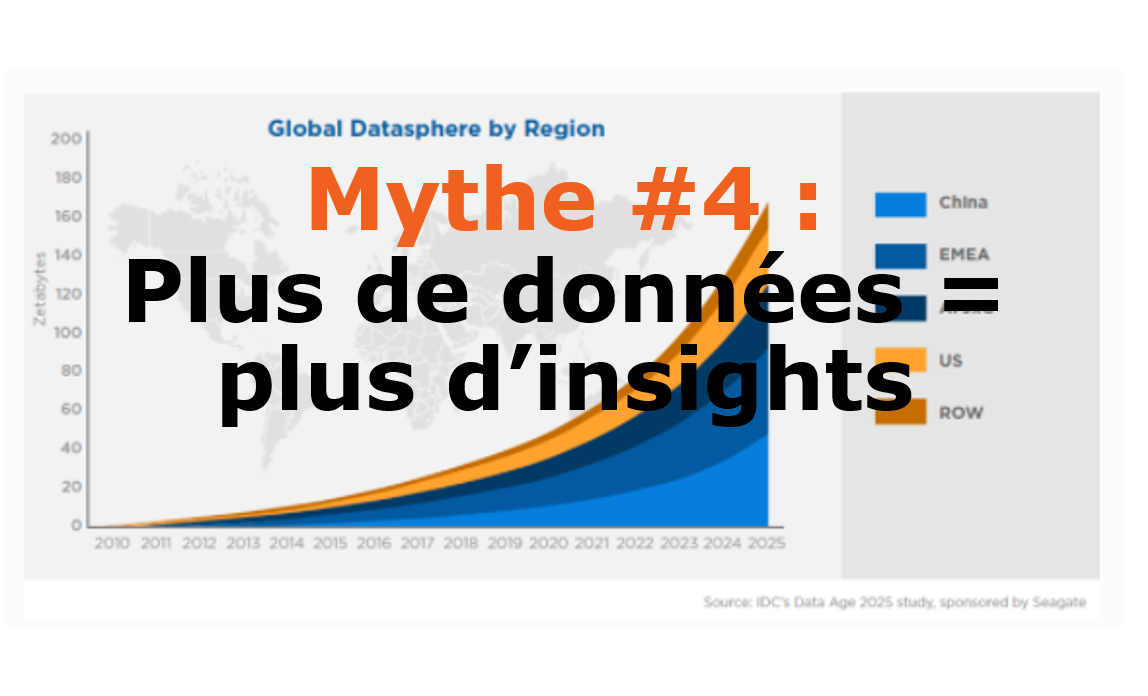

Dans un monde où la quantité de données générées chaque jour est en croissance exponentielle, où l’on entend toutes sortes d’analogies telles que les données sont le nouveau pétrole (data is the new oil), il est facile de penser que plus nous avons de ces données en notre possession, plus nous aurons d’insights. Mais est-ce vraiment le cas ?

Les 3 V

Tout d’abord, les données massives (big data) sont caractérisées par 3 éléments qu’on appelle souvent les 3 V, soit le volume, la variété et la vélocité.

- Le volume fait référence à la quantité massive de données

- La variété fait référence aux différents types de données comme le texte, l’audio, la vidéo, les photos, etc.

- La vélocité représente le mouvement rapide de ces données comme dans le cas de l’internet des objets qui produit énormément de données en continue

Il est important de comprendre que plus ces 3 V sont présents, plus la gestion et le traitement de ces données devient complexe et nécessite donc des ressources spécialisées afin de s’y retrouver.

Signal vs bruit

Tout comme le fait de chercher une aiguille dans une botte de foin, plus il y a de données et plus les insights y sont bien cachés et deviennent donc difficiles à identifier. On peut effectivement retrouver plus de signaux (insights) dans une grande quantité de données, mais on retrouvera également une plus grande quantité de faux signaux (bruit). Il devient donc parfois facile d’y faire des associations trompeuses ou même de dériver des informations carrément fausses.

La connaissance du contexte d’affaires est très importante afin de départir le signal du bruit. De plus, le domaine des statistiques peut aussi aider à identifier des relations statistiquement significatives entre certaines choses, mais un bon statisticien saura aussi remettre en doute ses conclusions. Bref, tout n’est pas noir ou blanc et il faut procéder avec beaucoup de prudence avec ces énormes quantités de données. Un excellent livre à ce sujet est « The signal and the noise » de l’auteur Nate Silver.

Par exemple

À titre d’exemple, la compagnie Google a lancé un projet autour des années 2010 afin d’utiliser la quantité astronomique de données reliées aux recherches faites par des utilisateurs (termes, zones géographiques, etc.) pour identifier le nombre moyen de personnes malades et même de prédire les éclosions. Tel que mentionné par les responsables de Google : « Bien que ce ne soient pas toutes les personnes qui cherchent pour le terme grippe qui sont actuellement malades, certains patterns semblent émergés lorsque toutes les requêtes sont fusionnées entre elles. » Il s’est finalement avéré que les prédictions faites par l’algorithme ont dépassé de plus du double le nombre réel de personnes malades en 2012-2013. Le projet a été abandonné peu de temps après.

En conclusion, voici une citation célèbre d’un économiste nommé Ronald Coase :

« If you torture the data long enough, it will confess. »

Poursuivez votre lecture…

Mythe #5 : Corrélation = causalité

Charles Michaud

Consultant en intelligence d’affaires